Gado-Scraper

Pipeline de Dados Serverless

Python (BS4)

GitHub Actions

Cron Jobs

Git Automation

O Objetivo

Este projeto nasceu de uma necessidade real do meu Sistema de Gestão de Gado (SGG). Para que os indicadores financeiros do ERP fossem úteis, eu precisava de cotações precisas e atualizadas da arroba do boi e novilha.

O objetivo, portanto, foi criar uma integração autônoma que alimentasse o SGG com dados reais de mercado, eliminando a necessidade de o usuário inserir valores manualmente todos os dias.

Arquitetura "Git-as-Database"

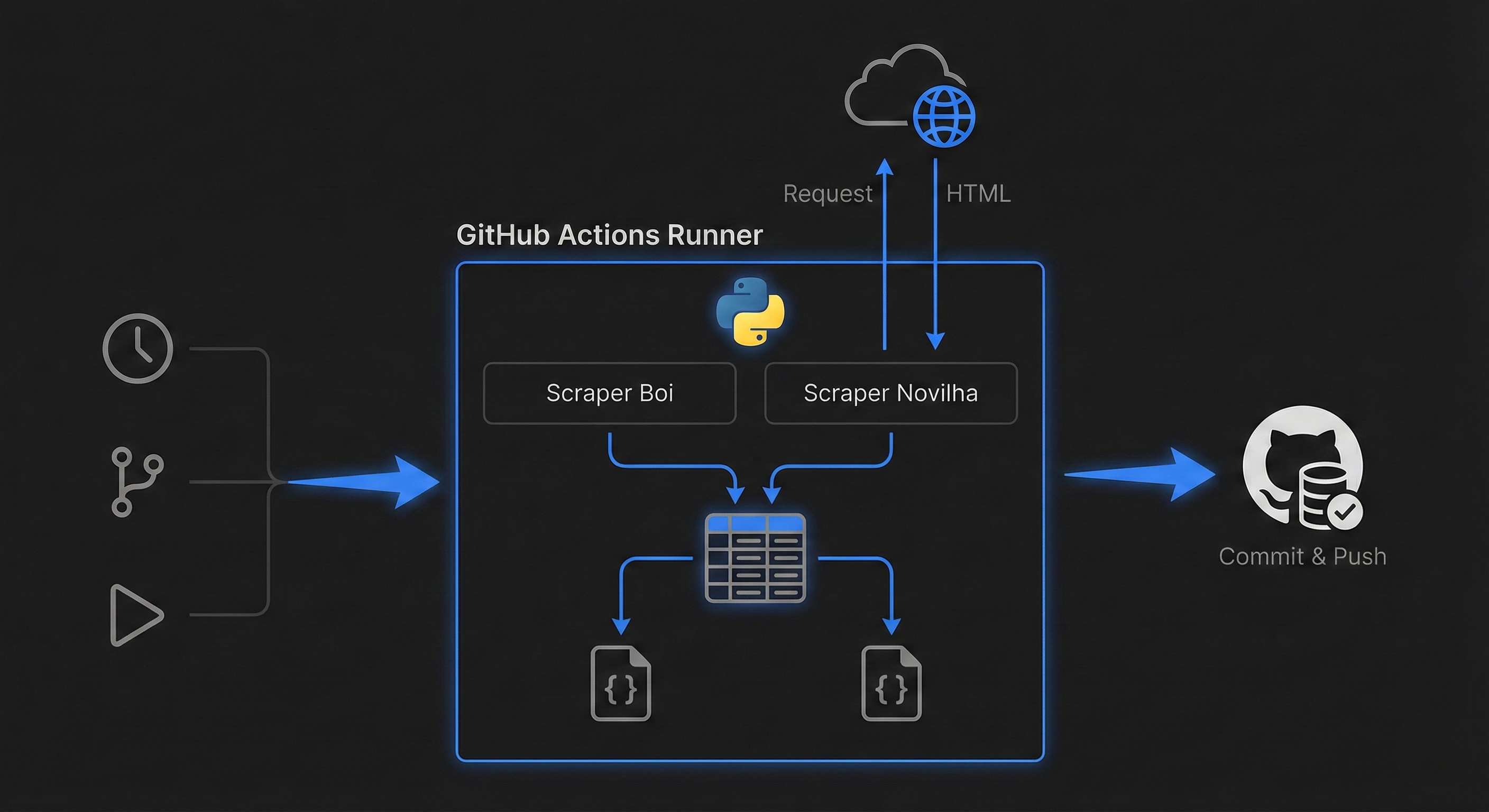

Ao invés de pagar por um servidor VPS para rodar um script simples, utilizei a infraestrutura do GitHub Actions como um runner gratuito e agendado.

O Workflow Diário (CI/CD):

- Trigger (Cron): O arquivo

atualizacao_diaria.ymldispara o container todos os dias em horário comercial. - Extração (Scraping): Scripts Python robustos navegam nas fontes de dados, tratam erros de conexão e extraem os valores.

- Persistência (Auto-Commit): O diferencial do projeto: o próprio robô commita os resultados (JSON) de volta no repositório, criando um banco de dados histórico versionado pelo Git, pronto para ser consumido via API (Raw URL) pelo SGG.

Ver Repositório